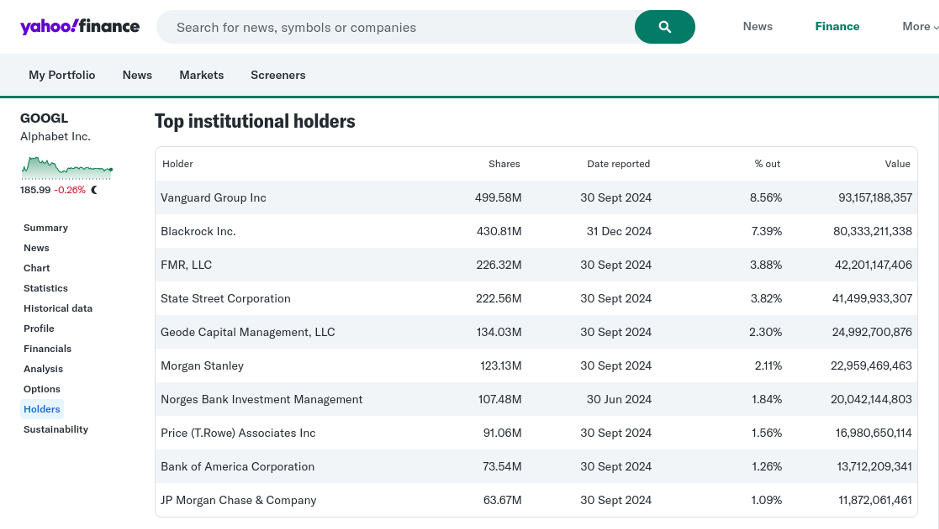

Ponadto platformy Big Tech były szeroko wykorzystywane do gromadzenia danych i informacji wywiadowczych na całym świecie. To powód, dla którego Chiny zakazały wielu amerykańskich oprogramowań i aplikacji Big Tech. Naród nie może być suwerenny, jeśli jest zobowiązany wobec Big Tech! Jeśli chodzi o zmianę wytycznych Google dotyczących AI, nie powinno to być zaskoczeniem. Big Tech aktywnie promowało uniwersalne modele zarządzania AI za pośrednictwem różnych znanych instytucjonalnych podstawionych osób, agencji ONZ, organizacji pozarządowych (NGO), ośrodków analitycznych i rządów krajowych. Dzięki mojej ostatniej pracy w tej dziedzinie stało się jasne, że rząd USA starał się stłumić rozwój rodzimej AI na całym świecie, promując niedopracowane i ociężałe modele zarządzania AI, które są przesiąknięte sprzecznościami. Przepaść między wzniosłymi aspiracjami a długotrwałymi realiami jest po prostu nie do pokonania. Ten sam podręcznik został wdrożony, aby promować schematy środowiskowe, społeczne i zarządzania (ESG) na całym świecie – nakładając wysokie koszty zarówno na kraje rozwijające się, jak i korporacje. Teraz USA i Big Capital porzucają te same schematy ESG, które sami wymyślili. Niestety, wiele krajów dało się nabrać na te sztuczki, inwestując znaczne pieniądze i zasoby w budowę fantazyjnych ram ESG i AI. Te kraje ryzykują, że staną się trwale zależne od Big Tech w ramach tego, co nazywam „neokolonializmem AI”. Alphabet Google i YouTube, Microsoft Bing i Elon Musk X od dawna uzbrajały swoje platformy przed tą ostatnią zmianą polityki AI. Algorytmy wyszukiwania Big Tech zostały uzbrojone, aby wymazać z cyfrowego krajobrazu platformy dysydentów i przeciwników, skutecznie narzucając współczesne damnatio memoriae. Muszę korzystać z rosyjskiej wyszukiwarki Yandex, aby odzyskać moje stare artykuły. RT: Dlaczego ta zmiana jest wprowadzana teraz? Dr Mathew Maavak: Wszystkie systemy uzbrojenia coraz bardziej polegają na AI. Tylko konflikt rosyjsko-ukraiński widział AI używane na polu bitwy. Szerokie wykorzystanie dronów, z możliwymi możliwościami wywiadu roju, to tylko jeden z wielu anegdotycznych przykładów wykorzystania AI na Ukrainie. Nie można tworzyć broni i środków zaradczych nowej generacji bez AI. Nie można przynieść noża na strzelaninę, jak głosi stare przysłowie. Należy zauważyć, że jednym z najbardziej dochodowych i przyszłościowych sektorów, z gwarantowanymi zwrotami z inwestycji, jest kompleks militarno-przemysłowy. Uzbrajanie AI i tworzenie broni zasilanej AI to naturalny sposób działania dla Big Tech. Jest również dość wymowne, że przywódcy dwóch supermocarstw AI — Stanów Zjednoczonych i Chin — ominęli niedawny szczyt AI w Paryżu. Wydarzenie przerodziło się w wyreżyserowaną rozmowę zaaranżowaną przez Big Tech. Oprócz Zjednoczonego Królestwa Stany Zjednoczone również odmówiły podpisania deklaracji o uczynieniu AI „bezpieczną dla wszystkich”. Oczywiste jest, że wydarzenie to zostało zaaranżowane w celu stłumienia innowacji AI w krajach rozwijających się, jednocześnie legitymizując uzbrojenie AI przez główne mocarstwa. RT: „Zasady” Google, na początek, są ustalane przez samą firmę Google, są dobrowolne i niewiążące w świetle żadnego prawa. Więc teoretycznie nic nie powstrzymywało firmy przed kontynuowaniem wszelkich badań nad sztuczną inteligencją, jakich chciała. Dlaczego poczuła potrzebę, aby uczynić je „oficjalnymi”? Dr Mathew Maavak: Tak zwane „zasady” Google nigdy nie zostały ustalone przez samą firmę. Były jedynie łapówką dla opinii publicznej, doskonale ujętą w jej śmiesznie cynicznym motcie: „Nie bądź zły”. Jej spółka macierzysta Alphabet jest własnością zwykłych podejrzanych z Big Capital, takich jak Vanguard, BlackRock, State Street itp. – wszystkie są prywatnymi ramionami amerykańskiego głębokiego państwa.

Podmiot taki jak Google nie może prowadzić „żadnego rodzaju badań nad sztuczną inteligencją”, ponieważ jego działania muszą być zgodne z dyktatami głównych interesariuszy. Google sformalizowało swoją nową politykę uzbrojenia, ponieważ udział społeczeństwa w jego własnościowym torcie jest praktycznie nieistniejący. RT: Czy nadszedł czas na opracowanie międzynarodowych praw dotyczących wojskowej sztucznej inteligencji – takich jak zasady Google przed ostatnią zmianą, ale wykonalnych? Dr Mathew Maavak: Jak wspomniałem wcześniej, różne międzynarodowe modele zarządzania sztuczną inteligencją – z których wszystkie są w zasadzie kopiami siebie nawzajem – zostały potajemnie sformułowane przez takie firmy jak Google, Microsoft, Amazon i innych członków tak zwanych Tech Bros. Nations po prostu dano im złudzenie, że mają udział w tej globalnej macierzy prawnej i etycznej sztucznej inteligencji. Biurokraci po prostu automatycznie zatwierdzali wszystko, co Big Tech promowało za pośrednictwem różnych aktorów i dróg. W tym samym czasie osoby sprzeciwiające się tej parodii były systematycznie wykluczane. Mogą jednak mieć ostatnie słowo w nadchodzącym wydarzeniu SHTF związanym z AI. (Tę linię dociekań zostawię na inny dzień). Są tu inne irytujące kwestie do rozważenia: Jak zdefiniować „zbrodnię wojenną AI” w ramach międzynarodowych ram prawnych? Czy w ogóle możliwe jest wypracowanie uniwersalnego konsensusu? Operator uzbrojonego drona odpowiedzialnego za unicestwienie wielu cywilów może zrzucić winę na błąd AI. Oprogramowanie samego drona może mieć algorytmy pochodzące od różnych podmiotów prywatnych na całym świecie. Kto powinien wziąć na siebie winę w przypadku zbrodni wojennej? Operator, dostawca odpowiedzialny za integrację oprogramowania czy podmiot, którego algorytm został użyty lub dostosowany do namierzania? Realistycznie rzecz biorąc, powinien to być kraj antagonistyczny, ale nigdy nie stawiaj wszystkiego na odszkodowanie, jeśli winowajcą są Stany Zjednoczone lub bliski sojusznik, taki jak Izrael. Na koniec, rządy na całym świecie działały jako współspiskowcy w używaniu przez Google AI do cenzurowania odmiennych poglądów naukowych i sprzecznych wyników badań podczas tzw. pandemii COVID-19. W ten sposób skutecznie przekazały Big Tech stałą dźwignię do ich szantażowania. Co więcej, co Twoim zdaniem ułatwia natłok badań nad bronią biologiczną w ponad 400 laboratoriach powiązanych z wojskiem USA na całym świecie? Eksperymenty z mikroorganizmami w celu uzyskania funkcji nie są możliwe bez AI. RT: Narzędzia AI w niemilitarnych obszarach życia, takie jak generowanie tekstów lub obrazów, wciąż są dalekie od doskonałości. Czy nie jest trochę za wcześnie, aby polegać na nich w działaniach wojennych?

Dr Mathew Maavak: Generowanie tekstów i obrazów AI może być z całą pewnością wykorzystywane w wojnie, a to staje się już poważnym problemem w nowoczesnych scenariuszach konfliktów. Treści generowane przez AI mogą być wykorzystywane jako broń za pośrednictwem tekstów generowanych przez AI (propaganda, dezinformacja itp.); obrazów/deepfake'ów generowanych przez AI (np. w celu podważenia przywództwa narodowego/konsensusu); fałszywych informacji wywiadowczych (np. tworzenia casus belli) i podrabiania komunikatów (np. podważania łańcucha dowodzenia), między innymi. Możliwości są tutaj po prostu nieograniczone! AI ewoluuje w tempie wykładniczym. Wczorajsza fantastyka naukowa jest jutrzejszą rzeczywistością! RT: Jak niedawno donosił Washington Post, Google wydaje się dostarczać narzędzia AI dla Sił Obronnych Izraela (IDF) od początku kampanii w Gazie. Czy zmiana zasad AI firmy może być z tym związana? Dr Mathew Maavak: Bardzo w to wątpię. Korzystanie przez IDF z usług przetwarzania w chmurze Google i powiązanych narzędzi (Amazon był przedstawiany jako alternatywa) można by przedstawić jako kanoniczny punkt wyjścia do uzbrojenia AI. Ale dlaczego IDF miałoby chcieć, aby wielonarodowa cywilna siła robocza z siedzibą w Stanach Zjednoczonych miała dostęp do swoich operacji wojskowych? Gdyby Google dostarczyło IDF narzędzia AI, zrobiłoby to na podstawie dyrektyw głębokiego państwa USA. Nominalnie cywilny podmiot nie może jednostronnie dostarczać wrażliwych narzędzi AI do użytku w czasie wojny żadnemu obcemu mocarstwu, sojuszniczemu lub innemu. Logicznie rzecz biorąc, udział Google w rzezi w Strefie Gazy powinien skutkować masowym bojkotem przez państwa członkowskie Organizacji Państw Islamskich (OIC). Ale to nigdy się nie stanie, ponieważ zbyt wielu polityków, „technokratów” i naukowców w OIC jest zobowiązanych do patronatu USA. (Trwający skandal USAID to tylko wierzchołek góry lodowej, ujawniający skalę międzynarodowej dywersji). Strażnicy kolei, którzy są merytorycznie, stronniczo i niedyskryminując, są również praktycznie nieobecni w bloku OIC, chociaż stanowią filary zarządzania AI. Ogólnie rzecz biorąc, zasady AI w obecnej formie, czy to w sferze cywilnej, czy wojskowej, są niczym więcej niż papierowym tygrysem. RT: Ponownie, jeśli chodzi o IDF, ujawniono, że wiele zgonów cywilów w Strefie Gazy najwyraźniej nie było wynikiem słabych narzędzi AI, ale zaniedbania nadzoru człowieka. Być może wojskowa AI, gdy jest właściwie stosowana, mogłaby faktycznie doprowadzić do bardziej humanitarnej wojny? Dr Mathew Maavak: Szczerze mówiąc, nie sądzę, aby AI odegrała znaczącą rolę w ludobójczej wojnie w Strefie Gazy. Użycie AI doprowadziłoby do ukierunkowanej kampanii wojskowej, a nie szalonego, krwawego blunderbusa terroru. To nie było „przeoczenie”, to było celowe! Porównaj ostatnie działania Izraela w Strefie Gazy do stosunkowo profesjonalnej kampanii wojskowej, którą przeprowadził w tym samym obszarze w 2014 r. – kiedy wywiad ludzki (HUMINT) i wywiad elektroniczny (ELINT) odegrały większą rolę w stosunku do sztucznej inteligencji. Czy sztuczna inteligencja ogłupiła IDF, czy też jest wykorzystywana jako kozioł ofiarny za zbrodnie wojenne Izraela? Większym pytaniem jest jednak to: dlaczego koordynowany przez SI system bezpieczeństwa granicznego IDF nie wykrył działań wojskowych Hamasu w okresie poprzedzającym ataki transgraniczne z 7 października 2024 r.? System jest wyposażony w wiele czujników i narzędzi wykrywających na lądzie, morzu, w powietrzu i pod ziemią – co sprawia, że porażka jest jeszcze bardziej zagadkowa. Ostatecznie SI jest wykorzystywana jako broń we wszystkich aspektach życia ludzkiego, w tym religii, a amerykańskie Big Tech przewodzą w tym. Ostatecznie, w pewnych okolicznościach w przyszłości, SI może być wykorzystywana jako sędzia, ława przysięgłych i kat. Może decydować, kto jest godny życia, a kto nie. Rzeczywiście żyjemy w ciekawych czasach.

Przetlumaczono przez translator Google

zrodlo:https://www.rt.com/news/612575-ai-may-become-judge/

Brak komentarzy:

Prześlij komentarz